當地時間週一,OpenAI春季發佈會重磅來襲,GPT-4o閃亮登場。

作為GPT-4 型號的最新版本,GPT-4o不僅在聽、説、看 方面更“絲滑”,並且將向所有用户免費開放。

OpenAI還稱,在接下來的幾周內,將開始向ChatGPT Plus展示新的語音和視覺功能。

“全能”的GPT-4o炸場

GPT-4o的“o”代表“omni”,即“全能”的意思。

據OpenAI介紹,GPT-4o是邁向更自然的人機交互的一步——它接受文本、音頻和圖像的任意組合作為輸入,並生成文本、音頻和圖像輸出的任意組合。

同時,它可以在短短232毫秒內響應音頻輸入,平均為 320 毫秒,與人類在對話中的響應時間相近。

而在此之前,GPT-3.5的平均延遲為2.8秒,GPT-4為5.4秒。

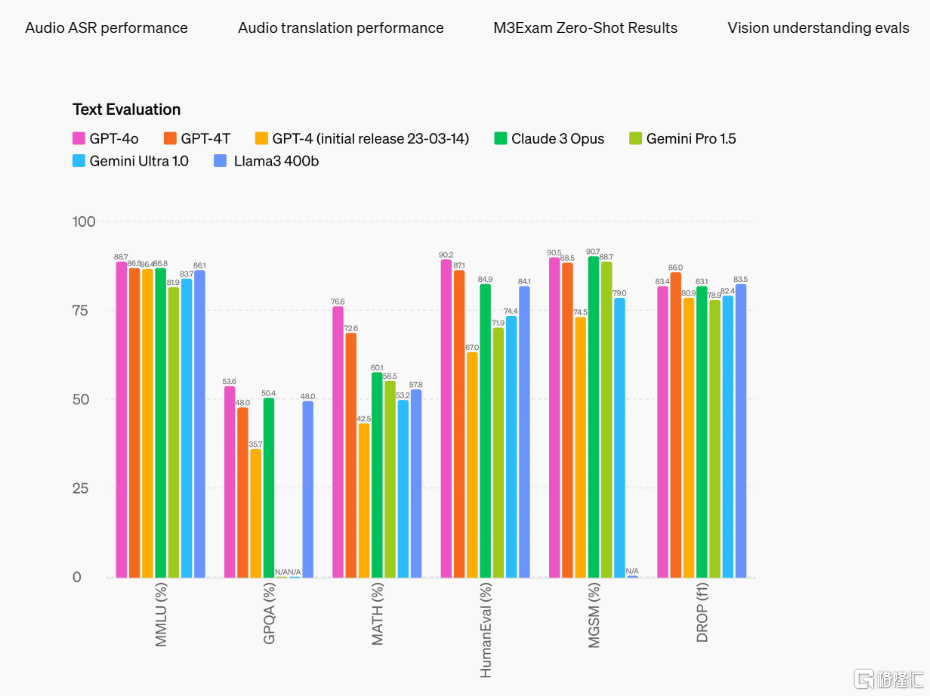

在英語文本和代碼上,GPT-4o的性能與GPT-4Turbo相當;在非英語語言的文本上也有顯着改進,同時在 API 中也更快且便宜 50%。

總的來看,與現有模型相比,GPT-4o 在視覺和音頻理解方面尤其出色。

“藉助GPT-40,我們可以跨文本、視覺和音頻端到端地訓練一個新模型,這意味着所有輸入和輸出都由同一個神經網絡處理。由於GPT-40是我們的第一個結合了所有這些模式的模型,因此我們對該模型的功能及其侷限性的探索還只是觸及表面。”

性能方面,按照傳統基準測試,GPT-4o 在文本、推理和編碼智能方面實現了 GPT-4 Turbo 級別的性能,同時在多語言、音頻和視覺能力方面的表現也創下了新高。

OpenAI 稱,GPT-4o現在支持50多種語言。

在現場直播中,OpenAi 首席技術官 Mira Murati 表示,ChatGPT 的更新版本現在還將具有記憶功能,這意味着它可以從之前與用户的對話中學習,並且可以進行實時翻譯。

“這是我們第一次在易用性方面真正邁出一大步。這種互動變得更加自然,也更加容易。”

現場,OpenAl高管還演示了與ChatGPT的口語對話,以獲得解決數學問題的實時指令,講睡前故事,並獲得編碼建議。

ChatGPT能夠用自然、人類的聲音説話,也能用機器人的聲音説話,甚至還能唱出一部分迴應。該工具還能夠查看圖表的圖像並進行討論。

OpenAI 和谷歌的新對決

值得關注的是,眼下AI大模型戰場的“廝殺”已十分焦灼。

OpenAI 和谷歌的對決更是激烈。

值得一提的是,這回OpenAI 的“大上新”正好挑在了谷歌 I/O開發者大會的前一天發佈。

稍早前,谷歌發佈了一條推文,展示了其 AI Gemini 聊天機器人的對話版本原型,該機器人使用視頻輸入而不是文本。

Gemini 不僅能夠正確、恰當地回答提出的問題,視頻還顯示聊天機器人在維持對話方面做得很好。

就在這段視頻發佈在“X”上不到一個小時後,OpenAI 首席執行官 Sam Altman的“X”上免費宣佈為 ChatGPT 提供類似功能。

而上一次,OpenAI也是在谷歌發佈Gemini 1.5 Pro後半小時左右用Sora狙擊了一把。

一場樸實無華的“商戰”似乎又在拉開大幕。

最近,有關OpenAI最新產品發佈的猜測已成為硅谷的一場遊戲。

此前,有消息傳OpenAI會發布GPT-5和搜索功能。雖然隨後公司闢謠了,但 GPT-4o對人工智能圈帶來的震撼依然不小。

在發佈會後,OpenAI 首席執行官 Sam Altman還談到了關於 GPT-4o 的一些想法,並強調了兩件事。

首先,OpenAI 使命的一個關鍵部分是將非常強大的人工智能工具免費(或以高昂的價格)交到人們手中。其次,新的語音(和視頻)模式是他用過的最好的計算機界面。

他還表示,很快就會有更多的東西可以分享。