當ChatGPT以迅雷不及掩耳之勢火爆全球之後,人類對AI的極速進化擔憂也愈發強烈。

上千名科學、企業家呼籲暫停巨型 AI 實驗

日前,生命未來研究所(Future of Life)發佈了一封《暫停大型AI研究》的公開信,其呼籲所有AI實驗室立即暫停比GPT-4更強大的人工智能系統的訓練,至少6個月。

據公開信表示,大量研究表明且得到頂級 AI 實驗室的認可,具有人類競爭智能的 AI 系統可能對社會和人類構成深遠的風險。正如廣泛認可的Asilomar AI 原則中所述,高級 AI 可能代表地球生命史上的深刻變化,應以相應的關懷和資源進行規劃和管理。不幸的是,這種級別的規劃和管理並沒有發生,儘管最近幾個月人工智能實驗室陷入了一場失控的競賽,以開發和部署更強大的數字思維,沒有人——甚至他們的創造者——都無法理解、預測、或可靠地控制。

公開信強調,我們不應該冒險失去對文明的控制,不得將此類決定委託給未經選舉產生的技術領導者。 只有當我們確信它們的影響是積極的並且它們的風險是可控的時候,才應該開發強大的人工智能系統。

其呼籲所有 AI 實驗室立即暫停至少 6 個月的訓練比 GPT-4 更強大的 AI 系統。這種暫停應該是公開的和可驗證的,並且包括所有關鍵參與者。如果不能迅速實施這種暫停,政府應介入並暫停。

人工智能實驗室和獨立專家應該利用這次暫停,共同開發和實施一套用於高級人工智能設計和開發的共享安全協議,並由獨立的外部專家進行嚴格審計和監督。但這並不意味着總體上暫停 AI 開發,只是從危險的競賽中倒退到具有緊急功能的更大的不可預測的黑盒模型。

與此同時,AI 開發人員必須與政策制定者合作,以顯着加快開發強大的 AI 治理系統。人工智能研究和開發應該重新聚焦於使當今強大的、最先進的系統更加準確、安全、可解釋、透明、穩健、一致、值得信賴和忠誠。

最後,公開信稱,我們人類已經暫停了其他對社會有潛在災難性影響的技術,對於人工智能技術,也應該如此對待。

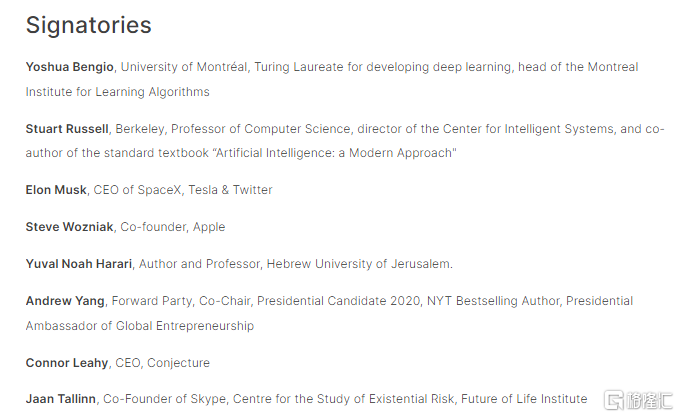

截止最新,這封公開信已有超1100人簽署。名單中,特斯拉創始人馬斯克、蘋果聯合創始人斯蒂夫·沃茲尼亞克、谷歌DeepMind首席執行官Demis Hassabis等在內的多名人工智能專家和行業高管等赫然在列。

AI可能會威脅到人類生存?

值得一提的是,近來對AI的擔憂聲愈發高升。

作為“AI威脅論”支持者的馬斯克此前曾多次表達對人工智能的擔憂。早前在ChatGPT 剛剛大火之際,他就曾發推文表示,OpenAI和創建初衷背道而馳。

OpenAI最初是作為一家開源的非營利性公司而創辦的,其目的是為了抗衡谷歌,但現在它已變成一家閉源的營利性公司,被微軟有效控制。

他也曾在多次講話中談到,人工智能是未來人類文明最大的風險之一。

日前,高盛也預警表示,大語言模型可能威脅 3 億工作崗位。ChatGPT 等生成式人工智能系統的最新突破,將給全球勞動力市場帶來重大顛覆。全球就業市場仍將受到大語言模型的嚴重衝擊,預計將有 3 億個工作崗位被生成式 AI 取代。

除了會搶走飯碗之外,也有一種觀點認為,OpenAI 創始人兼首席執行官 Sam Altman還表示,AI 可能毀滅人類,必須開發新技術來解決。

OpenAI創始人兼首席執行官Sam Altman3月25日在接受科技博客主Lex Fridman的採訪時表態,他不會迴避“人工智能可能殺死全人類”的説法。

在訪談中,Fridman提到了人工智能研究者、LessWrong研究所創始人Eliezer Yudkowsky此前指出“人工智能可能殺死所有人”的觀點,並認為,當人工智能發展為超級智能時,幾乎無法與人類站在統一戰線上。

對於此,Altman迴應道:

“我認為有這種可能性,並且承認這一點很重要,因為如果我們不談論它、不把它視為潛在的事實,那麼我們就不會投入足夠的努力去解決這個問題。”

“我認為我們必須開發新的技術來解決這個問題…我所知道的解決這類問題的*方法就是不斷迭代,儘早學習。”